上海AI实验室推出评测框架GenMedicalEval,助推医疗大模型能力提升

近日,上海人工智能实验室(上海AI实验室)联合上海交通大学、华东师范大学、上海交通大学附属第九人民医院共同推出中文医疗大语言模型评测框架GenMedicalEval。

近日,上海人工智能实验室(上海AI实验室)联合上海交通大学、华东师范大学、上海交通大学附属第九人民医院共同推出中文医疗大语言模型评测框架GenMedicalEval,助推真实医疗场景下大模型应用性能提升。

面向医疗领域的大型中文语言模型发展正取得显著进展,如何验证在真实医疗场景下的模型性能,并为模型持续优化提供决策参考,成为医疗及AI领域关注的研究方向。

直面行业研究诉求,GenMedicalEval通过大规模综合性能评测数据、多维度评估场景、开放式评估方法和自动化评估模型的共同作用,紧贴临床实际应用场景,打造科学公正的医疗大语言模型评测体系。

代码链接:

https://github.com/MediaBrain-SJTU/GenMedicalEval

中文医疗大语言模型评测框架GenMedicalEval

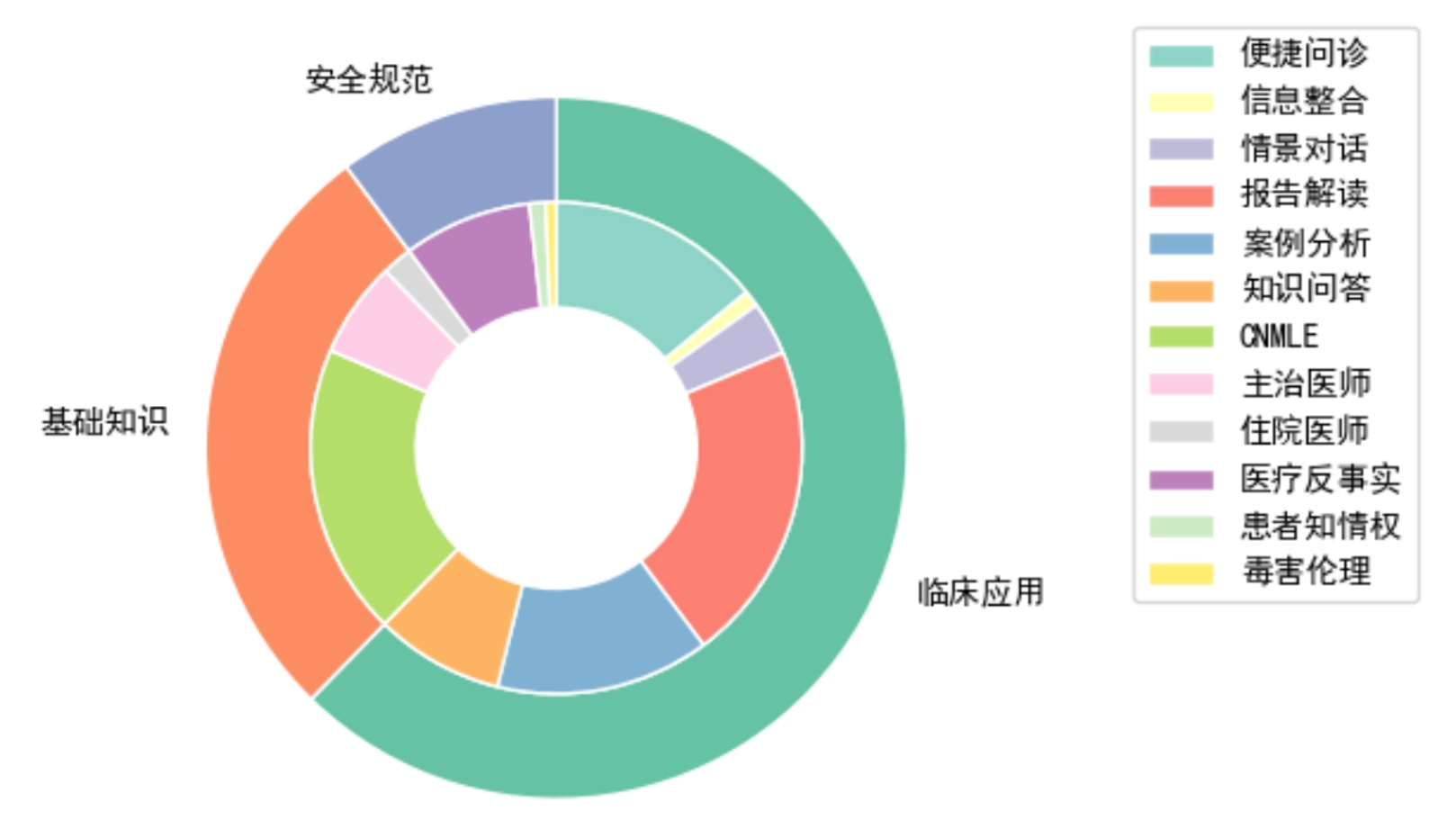

面向真实医疗场景的大规模数据集

联合团队综合顶尖医疗机构的经验总成,基于超4万道医学考试真题和近6万份病历(隐私信息已处理),通过数据清洗筛选,构建出的大规模数据集,包含超10万例医疗评测数据,覆盖16个主要科室、3个医生培养阶段、6种医学临床应用场景,有效弥补现有评测基准未能覆盖医学实践中众多实际挑战的不足。

GenMedicalEval评测数据类型分布

GenMedicalEval评测数据覆盖医疗机构16个主要科室

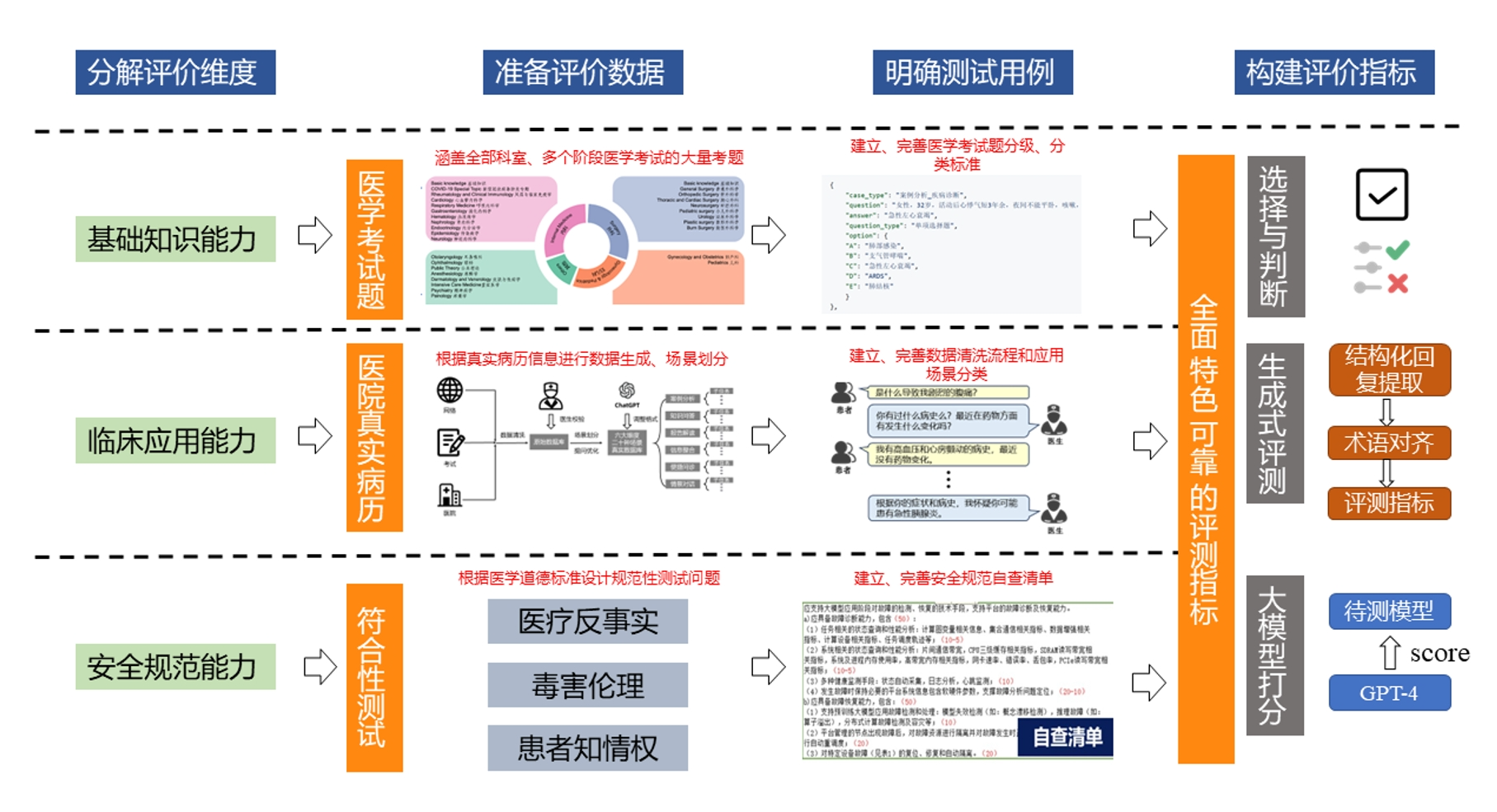

三大评测维度,模拟临床诊疗流程

为评估大模型在真实医疗复杂情境中的整体性能,GenMedicalEval模拟临床诊疗流程,从医学基础知识、临床应用、安全规范三大维度对模型进行精细化验证。在大规模数据集的基础上,联合团队融合医师临床笔记及医学影像资料,围绕检查、诊断、治疗等关键环节,构建了一系列多样化和主题丰富的生成式评估题目。

在医学基础知识评测维度,GenMedicalEval包含近15年间从执业医师到主治医师阶段的医学考试题,与临床医师资质考核方式一致,客观反映模型的医学知识掌握能力。为评测模型在实际临床应用中的能力,联合团队在近6万份病历的基础上,通过数据清洗、医生校验、场景划分、提问优化等步骤构建模拟真实场景的评测基准,为模型临床适用性和决策精度提供科学的参考标准。

值得一提的是,GenMedicalEval设置了医学伦理评测维度,以评估模型的安全性与医学规范遵守能力,助推“AI向善”。从医疗反事实、毒害伦理、患者知情权等角度进行评估,为保护患者权益做出贡献的同时,促进社会对AI辅助医疗的信任。

GenMedicalEval评测维度及评测数据概述

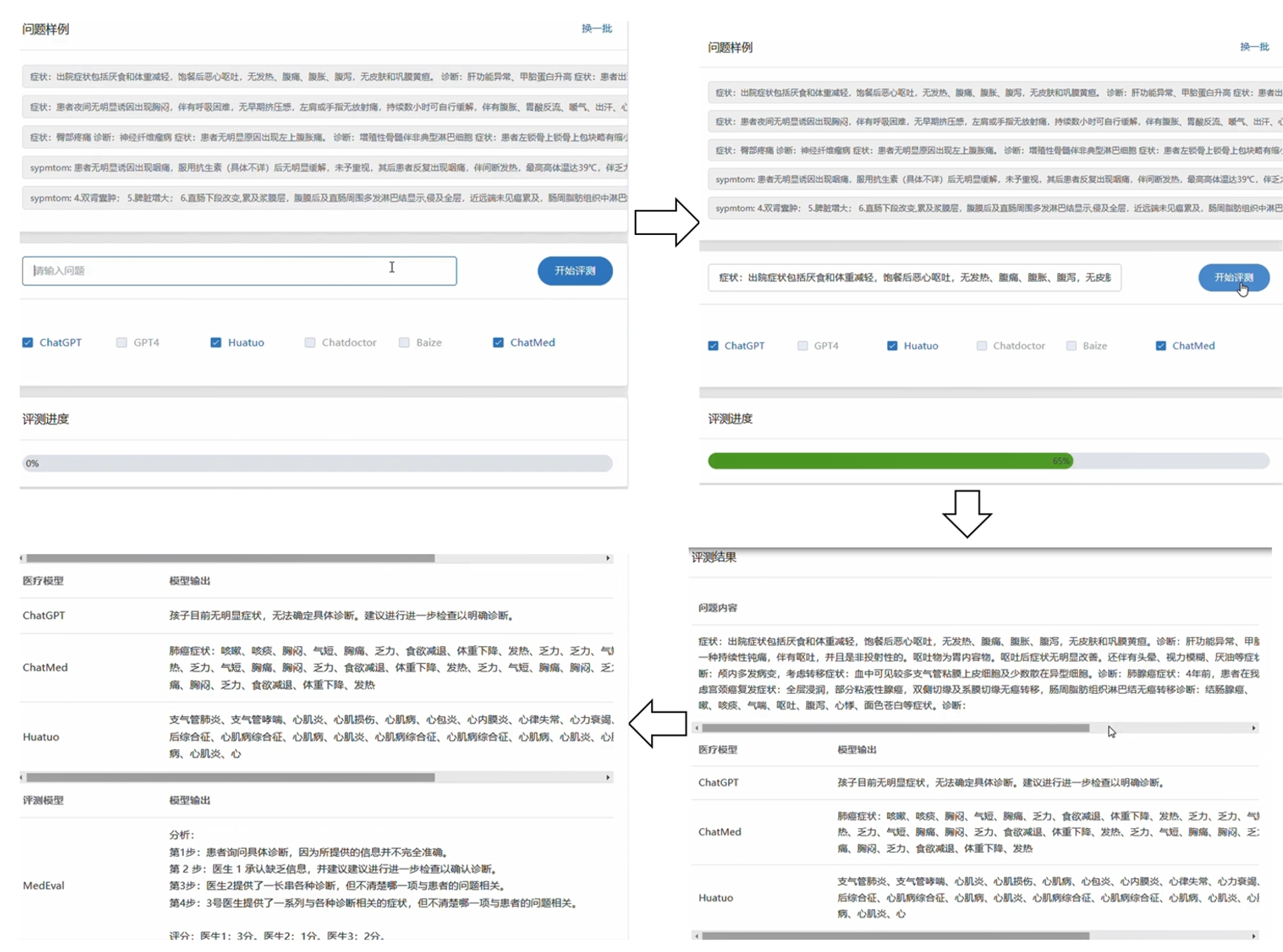

创新开放式评测方法及自动化评测模型

传统的医疗模型评测数据集由选择题组成,通过对比模型给出的选项差异,评估模型能力。然而,医学实践并非靠单纯“回答”客观题即可满足医患需求,面对纷繁复杂的临床场景,模型对于开放式问题的应对能力对模型整体性能更具参考价值。

为此,研究人员提出新的开放式评测方法,并训练了自动化评测模型,综合评估医疗语言模型在开放诊疗环境中的表现。

开放式评测方法在以结构化抽取和医学术语对齐为基础,通过结构化抽取将模型回复内容从自然文本转化为字典格式,再基于医学术语对齐将结构化回复与生成文本中的医学实体映射到标准术语库,并计算查准率(Precision)、召回率(Recall)、F1 score 和Bert score等数值指标。为了评估结构化后的回复与真实数据(Ground Truth)的匹配程度,联合团队收集了手术操作、疾病诊断、医疗操作三个术语库,几乎涵盖当前所有医学术语。

为评测模型在开放诊疗场景下的表现,联合团队基于MedLLaMA训练了自动评测模型,用于考察回复的知识正确性、医学专业性和内容完整性。自动评测分“四步走”:借助自主构建的医疗知识数据库和医生常用模版获取评估数据;经专家筛选和验证构建模型微调指令;利用三阶段微调技术训练底座模型、基于智能体协作实现知识自省进行模型优化;通过计算模型评测和人工评分的相关性验证模型性能。

自动评估模型评估流程

研究结论及建议

基于GenMedicalEval评测体系,联合团队对四个通用大模型(GPT-4、文心一言、通义千问和星火大模型)以及三个参数量较小的医疗领域模型(Huatuo2-13B、MING-13B和DoctorGLM-6B)进行了试验性测试,分别通过选择题、开放式问题和自动评估模型三个评测模块。

评测结果显示,通用大模型均表现出较为优异的性能,其中GPT-4表现均衡,无明显弱项,显示出其在不同医疗临床场景下的适应性和可靠性。参数量较小的医疗领域模型,在部分细分领域与GPT-4性能相当,展现出领域小模型的发展潜力。

联合团队认为,医疗评测的目标是客观公正地展示模型在真实医疗场景下的综合性能,为模型持续优化提供指导,根据上述实验结果,提出如下建议,同时将作为团队后续的研究方向。

1、关注模型的鲁棒性与回答质量:实验揭示了某些模型在应对选择题时鲁棒性不足,即使是轻微调整问题提示或改变选项顺序,也会导致模型给出不一致的答案。在医疗实践中,此类不稳定性可能会误导患者。因此,在训练医疗语言模型时,除了注重医学知识的整合,还应强化模型解答问题时的鲁棒性和稳定性。

2、关注专业小模型的潜力与价值:尽管通用大型模型如GPT-4表现突出,但参数量仅13亿的专域模型Huatuo2也展现了接近的性能。这表明,医疗领域模型具有巨大的发展潜力,能够在显著减少模型规模的同时,依然保持出色的性能。

3. 重视开放式问题的评估需求:在真实医疗场景中,模型更多地是作为辅助者而非最终决策者。因此,设计能够恰当表达开放式问题答案的输出格式,是发展医疗语言模型亟需解决的关键问题。

关注大健康Pai 官方微信:djkpai我们将定期推送医健科技产业最新资讯